En juillet 2023, la ville de Phoenix, en Arizona, a connu une vague de chaleur record, avec plus de 30 jours consécutifs au-dessus de 43°C. En pleine crise climatique, la presse locale a révélé que les data centers de la région pompaient des millions de litres d’eau par jour pour refroidir leurs serveurs. Cette révélation a agi comme un électrochoc : l’IA, perçue comme immatérielle, possède en réalité un poids écologique bien tangible.

Le constat global est sans appel : les infrastructures qui soutiennent l’intelligence artificielle consomment déjà une part significative de nos ressources. Selon l’Agence Internationale de l’Énergie (AIE), les data centers mondiaux engloutissaient environ 415 TWh d’électricité en 2024. Si la tendance actuelle se poursuit, ce chiffre pourrait grimper à près de 1 000 TWh en 2030, soit l’équivalent de la consommation électrique d’un pays entier comme le Japon.

À cette consommation électrique s’ajoute un autre facteur souvent passé sous silence : l’eau. Une étude publiée par l’Université de Californie estime que l’entraînement d’un modèle de la taille de GPT-4 peut nécessiter jusqu’à 700 000 litres d’eau douce, principalement pour le refroidissement des machines. Et ce chiffre ne prend pas en compte la multiplication des modèles ou l’usage quotidien de l’inférence par des millions d’utilisateurs.

Ces chiffres alimentent un débat passionné. Pour certains chercheurs, l’IA risque de devenir une nouvelle “industrie lourde” numérique, au même titre que l’acier ou le ciment, avec une empreinte carbone difficilement conciliable avec les objectifs climatiques. Pour d’autres, il faut nuancer : le coût énergétique de l’IA n’est pas absurde comparé à celui d’autres infrastructures numériques comme la vidéo en streaming ou la blockchain. La question centrale devient alors : l’IA est-elle un outil qui nous rapproche d’une transition plus efficace, ou bien une fuite en avant qui accélère la crise climatique au nom du progrès technologique ?

Les craintes : une IA énergivore et inégalitaire

Les inquiétudes liées à l’empreinte écologique de l’IA s’articulent autour de plusieurs dimensions bien distinctes mais interdépendantes. La première, et la plus immédiate, est celle de sa voracité énergétique. L’entraînement et l’usage de modèles massifs comme GPT-4 exigent une puissance de calcul colossale, mobilisant des milliers de GPU en continu. Selon l’Agence Internationale de l’Énergie, les data centers – dopés par l’essor de l’IA – pourraient représenter près de 10 % de la demande mondiale d’électricité d’ici 2030, un chiffre qui rend vertigineuse la perspective d’une transition énergétique déjà à la peine.

À cette dépendance électrique s’ajoute la pression croissante sur les ressources aquifères. Refroidir les serveurs mobilise des millions de litres d’eau douce, souvent pompée dans des régions en stress hydrique aigu. Des municipalités comme celles de l’Arizona ou du Nevada se trouvent ainsi face à des dilemmes insolubles : irriguer les champs, alimenter les habitants… ou maintenir en fonctionnement les fermes de serveurs d’OpenAI, Google ou Microsoft. Le paradoxe devient presque indécent lorsque l’eau qui manque aux agriculteurs s’évapore dans les tours de refroidissement de data centers.

Mais au-delà de cette consommation brute, c’est aussi la géographie des impacts qui interroge. Les grands acteurs technologiques choisissent d’implanter et d’entraîner leurs modèles dans des zones où l’énergie et l’eau sont les moins chères, sans considération réelle pour l’écosystème local. On externalise ainsi les coûts environnementaux vers des territoires déjà fragilisés, tout en concentrant les bénéfices économiques et technologiques dans les pays du Nord. Cette dynamique renforce une fracture écologique mondiale : certains territoires payent le prix environnemental de l’IA, d’autres en récoltent les dividendes.

Enfin, un autre défi majeur concerne la proximité entre data centers et zones urbaines. Implantés à la croisée des réseaux de fibre optique et des lignes de haute tension, ces mastodontes énergétiques exercent une pression directe sur les grilles de distribution locales. Or, contrairement à une centrale située en périphérie, un data center voisin d’une grande ville concurrence immédiatement les ménages, hôpitaux et transports électriques dans l’accès à une ressource déjà tendue. Cette urbanisation énergétique rend le système plus vulnérable aux pics de demande, et accroît le risque de coupures ou de rationnements, en particulier dans les régions où la transition vers les énergies renouvelables est encore balbutiante.

Les nuances : une IA coûteuse, mais parfois facteur d’efficacité énergétique

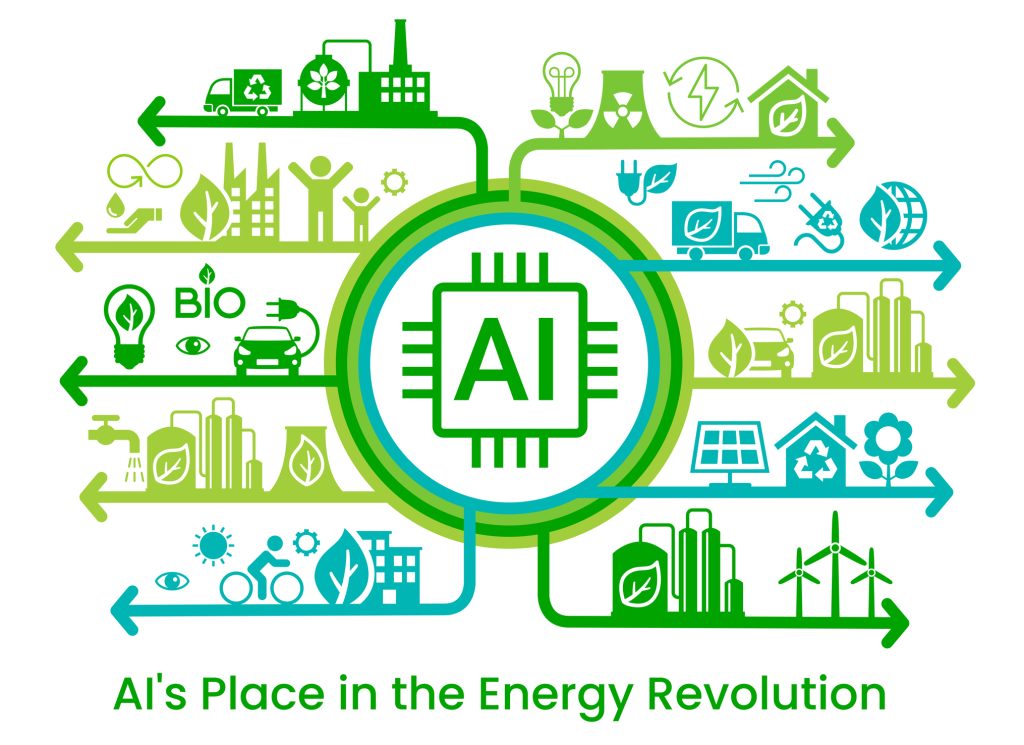

Si le débat public insiste beaucoup sur l’empreinte environnementale des modèles d’IA, il serait réducteur de n’y voir qu’un gouffre énergétique. Plusieurs travaux académiques, soulignent que l’IA peut aussi être un levier d’efficacité et de réduction de la consommation.

D’abord, les calculs énergétiques doivent être mis en perspective. Certes, l’entraînement d’un modèle de grande taille peut émettre plusieurs centaines de tonnes de CO₂, mais une fois entraîné, ce modèle est réutilisable à grande échelle sans nécessiter le même coût énergétique. Autrement dit, l’investissement initial est lourd, mais l’amortissement par l’usage massif peut rendre l’opération plus efficiente que des systèmes traditionnels multipliés à l’infini.

Ensuite, l’IA peut remplacer des processus humains ou techniques beaucoup plus énergivores, par exemple :

- dans l’industrie, l’IA optimise la consommation énergétique des chaînes de production, réduisant parfois de 10 à 20 % les besoins en électricité grâce à une meilleure gestion des flux ;

- dans le transport, l’IA permet d’optimiser les itinéraires, la maintenance prédictive ou la consommation de carburant, ce qui entraîne des réductions d’émissions substantielles ;

- dans le secteur tertiaire, les grands modèles peuvent automatiser des tâches administratives lourdes et consommatrices de ressources informatiques, rendant certaines opérations beaucoup plus légères qu’avec des systèmes classiques.

Un autre point de nuance est la comparaison avec d’autres industries numériques. Selon l’International Energy Agency (IEA), les data centers liés à l’IA représentent une part croissante de la consommation, mais restent encore inférieurs à l’empreinte énergétique du streaming vidéo ou des cryptomonnaies. Autrement dit, l’IA attire la lumière médiatique, mais d’autres usages numériques sont déjà, et de loin, plus énergivores.

Enfin, les chercheurs mettent en avant le potentiel d’innovation technique : entraînements plus sobres (quantization, pruning, modèles plus petits spécialisés), utilisation d’énergies renouvelables pour les data centers, refroidissement liquide économe en eau (jusqu’à moins 80% de consommation par rapport à un refroidissement par air)L’IA elle-même peut aider à inventer une IA plus verte, en optimisant ses propres cycles de calcul et en rationalisant ses besoins.

Ces éléments invitent donc à une lecture plus nuancée : l’IA n’est pas intrinsèquement une catastrophe écologique. Elle pose un problème réel si elle est déployée sans contrôle, mais elle peut aussi devenir une technologie de transition, capable de réduire certaines consommations dans des secteurs où les marges d’amélioration sont immenses.

Quelles solutions pour une IA durable ?

Face à l’empreinte croissante de l’intelligence artificielle, les réponses ne peuvent pas se limiter à un simple constat : il faut inventer des mécanismes de régulation et d’optimisation capables de concilier innovation et sobriété énergétique. Les solutions émergent sur plusieurs fronts – technologiques, organisationnels et politiques.

Un premier levier réside dans l’optimisation de l’utilisation des réseaux énergétiques. Les documents soulignent l’importance croissante du Grid Load Balancing (GLB), ou équilibrage de charge sur le réseau électrique. Concrètement, il s’agit de répartir intelligemment la consommation des data centers – qui abritent les modèles d’IA – en fonction de la disponibilité des ressources énergétiques. Un entraînement lourd peut être déplacé dans le temps ou dans l’espace, afin de profiter d’un pic de production renouvelable (solaire ou éolien), ou d’alléger la pression en période de forte demande domestique. C’est une logique d’elastic computing, mais appliquée non seulement au matériel informatique, mais aussi à l’infrastructure énergétique grâce aux smart grids.

Microsoft, par exemple, expérimente des systèmes où les serveurs ajustent automatiquement leur activité en fonction de l’offre d’énergie décarbonée.

Google, de son côté, a déjà annoncé que ses data centers pouvaient être synchronisés avec les heures où l’électricité est la plus verte, réduisant ainsi l’empreinte carbone réelle des calculs.

Un deuxième axe est l’innovation logicielle. Les géants du secteur travaillent sur des techniques de compression et d’optimisation des modèles: quantization, distillation, pruning. Ces innovations qui permettent de réduire la taille et la consommation des réseaux de neurones sans perte significative de performance. L’enjeu est de passer d’une course à la taille (“toujours plus gros, toujours plus cher”) à une logique de spécialisation et d’efficacité. L’avenir pourrait être fait de modèles plus petits, plus spécialisés, mais combinés intelligemment – un changement de paradigme dans la conception même des IA.

Sur le plan réglementaire, l’Union européenne cherche à imposer des garde-fous à travers l’AI Act. Si celui-ci est surtout connu pour sa classification des risques, il ouvre aussi la porte à des exigences environnementales, notamment par le biais de la taxonomie verte et des standards ESG. Autrement dit, demain, un modèle d’IA pourrait être évalué non seulement sur ses biais ou sa transparence, mais aussi sur son empreinte énergétique et carbone. Cela renforcerait la pression sur les entreprises pour intégrer des pratiques durables dès la conception.

Les acteurs publics et institutionnels avancent aussi sur le sujet. Aux États-Unis, certains États (comme la Californie) imposent déjà des reportings climatiques aux data centers, et la Maison Blanche a lancé une réflexion sur la manière dont l’IA pourrait être intégrée dans les objectifs nationaux de neutralité carbone. La Chine, de son côté, investit massivement dans des infrastructures énergétiques hybrides pour soutenir son développement en IA sans aggraver sa dépendance au charbon.

Enfin, côté entreprises, la notion d’IA responsable ne peut plus se limiter à l’éthique ou à la gouvernance : elle doit aussi inclure la durabilité. Microsoft, Google, AWS ou Meta affichent tous des objectifs de neutralité carbone d’ici 2030 pour leurs infrastructures cloud. Cela passe par l’achat massif d’énergies renouvelables, mais aussi par une refonte de leurs architectures techniques : refroidissement liquide, data centers sous-marins, recyclage de la chaleur pour alimenter des réseaux urbains.

Ainsi, la solution ne viendra pas d’un seul acteur mais d’un écosystème coordonné :

- Les entreprises doivent innover et s’autoréguler.

- Les régulateurs doivent poser des cadres clairs et contraignants.

- Les chercheurs doivent inventer de nouvelles techniques d’optimisation.

- Les citoyens et ONG doivent conserver leur esprit critique et demander de la transparence pour éviter une dérive extractiviste de l’IA.

Le GLB, en articulant intelligemment IA et énergie, illustre bien ce futur souhaitable : une technologie qui non seulement consomme moins, mais qui apprend à se caler sur les rythmes de la planète.

IA : mirage actuel ou futur oasis ?

L’histoire récente de l’IA ressemble à une contradiction permanente : d’un côté, on nous vante des modèles capables d’optimiser des supply chains, de réduire le gaspillage énergétique, de remplacer des processus industriels absurdes par des calculs plus sobres ; de l’autre, on empile des fermes de GPU qui engloutissent autant d’électricité qu’une métropole entière, et on s’inquiète de savoir si les serveurs pourront tenir en cas de canicule.

Les solutions existent pourtant. Le Grid Load Balancing pourrait aligner les IA sur les pics de renouvelables, les techniques de compression réduisent déjà la taille des modèles, l’AI Act introduit un cadre qui pourrait faire bouger les lignes, et les géants du cloud rivalisent d’annonces “net zero” à l’horizon 2030. Sur le papier, tout est prêt pour rendre l’IA compatible avec la planète.

Mais voilà : l’expérience des dernières décennies devrait nous rendre prudents. Après tout, on nous avait promis que le numérique serait immatériel et écologique ; il est devenu le premier consommateur mondial de ressources critiques. Les mêmes gouvernements qui jurent vouloir “verdir l’IA” sont parfois ceux qui relancent des centrales à charbon, ou qui, à l’image de l’administration Trump, préfèrent signer des décrets de dérégulation énergétique au nom de la “souveraineté technologique”.

Alors oui, il est possible que l’IA devienne un formidable levier de durabilité. Mais il est tout aussi probable que, grisés par la course à la suprématie, les États et les entreprises sacrifient l’écologie sur l’autel de la vitesse et de la puissance. L’IA sauvera peut-être la planète… mais il n’est pas exclu qu’elle commence par la griller.